【ハッカソン体験記 前編】MITメディアラボで開催された史上最大規模のVR/ARハッカソンに潜入”Reality, Virtually, Hackathon”

2016年10月7日から10日の間、米国マサチューセッツ州ケンブリッジにある、MITメディアラボにて、”Reality, Virtually, Hackathon”というハッカソンが行われました。DG LabのVR/AR担当として参加し、体験してきました。

今回のハッカソンでは、ARまたはVRの技術を用いて、(建築 / 工学 / 建設)(ヘルスケア/ 製薬)(ゲーム / エンターテイメント)(広告)(教育)分野などにおける新しい可能性を探る新しいアプリケーションをつくることがテーマとなりました。

ハッカソンには、住んでいる場所や経験によらず誰でも参加可能で、今回は世界中から1,000人以上が応募し、その中から選ばれた約350人が参加しました。主催者によると、VR/ARハッカソンとしては史上最大規模とのこと。参加者のバックグラウンドは、開発者、エンジニア、デザイナー、グラフィックアーティストといった具合に多岐に及びます。2日間の開発期間を経て、最終的には75の成果物が提出されました。

<スケジュール>

4日間(手を動かしてアイデアを実装していくのに当てられたのは2日間)

10/7 (金):ワークショップ

9:30am – 5:00pm ワークショップ

7:00pm – 8:00pm キックオフとキーノート

8:00pm – 9:00pm アイデアピッチとポスターセッション

9:00pm – 10:00pm チーム結成 (チーム結成後に帰宅 ※24時頃まで行われた)

10/8 (土): ハッカソン

9:30am – 11:30am ハッカソン(開発・実装)

11:30am – 1:00pm ランチ

1:00pm – 6:30pm ハッカソン(開発・実装)※1AMまで作業可

6:30pm – 8:00pm ディナー

10/ 9(日): ハッカソン

9:30am – 11:30am ハッカソン(開発・実装)

11:30am – 1:00pm ランチ

1:00pm – 3:00pm ハッカソン(開発・実装)

3:00pm – 6:00pm 第一講評

6:00pm – 8:00pm 懇親会

7:00pm – 7:15pm セミファイナリストの発表

10/ 10(月): 発表

11:00am – 3:00pm VR成果展示の発表日

3:00pm – 4:00pm 閉会式(優勝者発表)

<チーム結成の流れ>

シンキングタイムなしのスピード感あるアイデアピッチ

①キーノート / ルール説明

- チームは初日にその場で即席でつくる、ただし人数は5人以下にする

- 開発に使用するものは、無料で使えるもののみ

- 成果物はオープンソースにして、一般に公開する

- メンターや、他のチームにヘルプを出すことは柔軟に行える

- 最終日の発表ではスライドは使用禁止。動いてるデモを見せる

3番目のオープンソースについては、MITメディアラボらしく、オープンイノベーションを推進する姿勢が見られました。

5番目についても、MITメディアラボの”Demo or die”の精神、謂わば「デモで見せられなければ意味がない」という、ごまかしの効かない成果発表となりました。

②アイデアピッチ

昨今、海外で行われる大規模なハッカソンでは、時間をかけてアイデアを練る「アイデアソン」がなくなるといった動きがあるようですが、今回のハッカソンでもアイデアピッチがすぐに行われました。まずは、教育分野、エンターテイメント分野などといったカテゴリに分かれ、自分のアイデアを訴え、賛同する仲間を集めていきチームメンバーの募集を行ないます。

参加前に既にネタを考えていた人がいたのかもしれませんが、シンキングタイム無しで、いきなりアイデアピッチが次々と行われ、流れはスピード感を持って進んでいきました。ちなみに、私はそれぞれの分野を回りながらアイデアを聞いて回っていましたが、既にアイデアをまとめている参加者が多く、あれこれ迷っていたのでこの段階では後手に回ってしまいました。

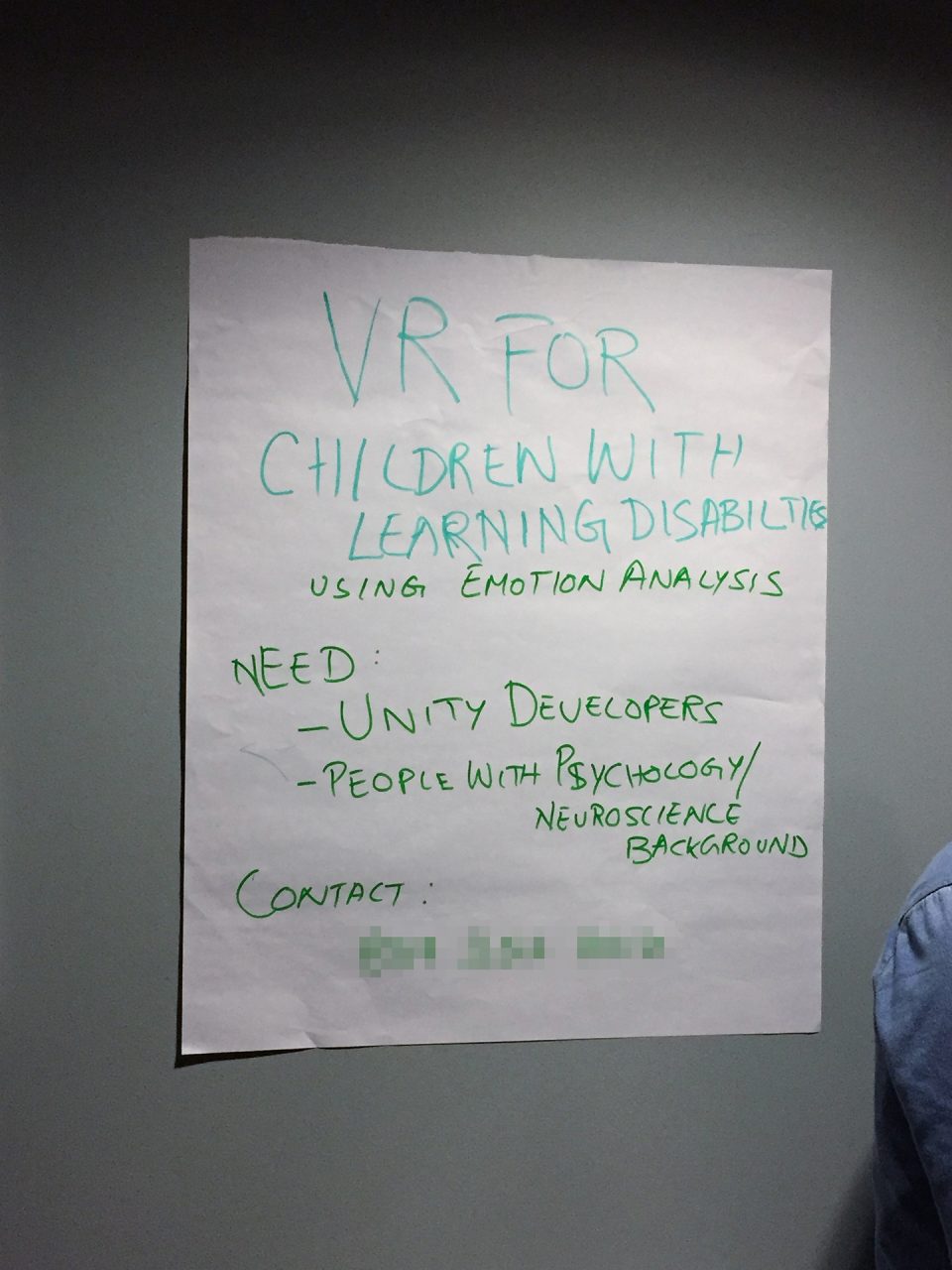

③ポスターセッション

その後、アイデアをまとめたポスターを制作し、壁に掲示し、その前でアイデアについて説明するセッションが行われました。自分のアイデアでチームをつくる、もしくは他の人のアイデアに乗っかってチームに参加する、またはそのための交渉が行われました。

ポスターには以下の3点の情報が書き込まれました。

- アイデア

- 必要なスキルセットのメンバー

- 連絡先(電話番号)

掲示されたポスターの例

メンバーが上限5人ということもあり、チームに入りたくても、募集している人材内容とマッチしない場合は断られるといったこともあり、各チーム必要なスキルセットを揃えるのに苦労していたようです。最終的にはUnityデベロッパー(VR/ARの技術開発者)の取り合いになるといったシーンも見受けられました。

④チームメンバー募集ピッチ

最後に、全体に向けてアイデアを説明していきます。参加者も多いので、限られた時間でピッチをしなくてはならず、短い時間で確実に説明することが求められました。この段階では既に3人程度のチームができているところが多く、アイデアの実現のために現状足りないのはどんな人材なのかが強調されました。

<チームができるまで>

チームビルディングもサバイバル!

私は、一日目のディナーの時間でBiswarajさんと話し、VRで学習障害者のための教育コンテンツを作れないかと話していました。記号、文字といった抽象的なものを避けて、具体的なイメージをVR上で見せることで、学習障害者にもわかりやすいコンテンツを提供できると考えました。また、私が持参した脳波計と、感性アナライザを利用して、学習者の集中度合いをモニタリングすることで、体験者の感情に応じてVRコンテンツを変化させ、体験者の注意を常に引きつけることで学習効果を向上させられないかとも考えていました。彼と意気投合したものの、実装するには学習障害と教育に詳しい人、そしてUnityエンジニアが必要でした。

一方、PatさんとNabanitaさんは、本をVR上で読ませるというアイデアでチームをつくろうとしていました。彼らは、本の文字情報から、音声合成で読み聞かせを行い、さらに本の内容の雰囲気にVR空間をデザインすることで読書の体験をアップグレードするというアイデアを持っていました。しかし彼らも同様に、Unityエンジニアを探していました。

彼らと話した所、VRならではの教育を考えていること、また文字よりもVRを見せる方が明解だという意見が共通したため、チームを一つにまとめることにしました。

チームは上限5人のため、あと1人、Unityエンジニアを探しました。1日目では見つからず、ハッカソンのFacebookグループに募集の書き込みをしました。すると2日目の朝にUnityエンジニアのAdrianさんが加入し、チームを結成することができました。

<参加したチームのプロジェクト紹介>

私が参加したチームは、”VR Story Tellers”という名前のチームで、メンバーとその担当分野は以下の通りです。

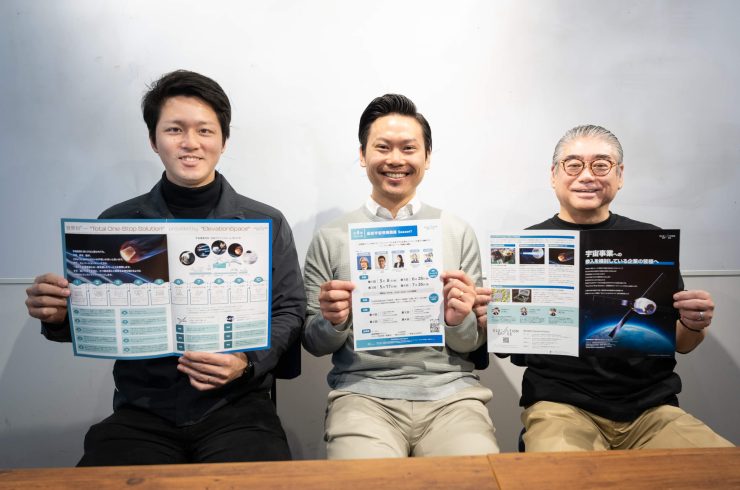

写真左から(名前 / 担当分野)

- 藤賀雄太: サウンドデザイン / Unity 音開発

- Biswaraj Kar: 自然言語処理 / 機械学習

- Adrian Babilinski: Unity VR開発

- Nabanita De: 自然言語処理 / 機械学習

- Pat Pataranutaporn: ウェブアプリ

VR Story Tellersのアイデアは「テキストからVR」というシンプルなもので、文章からその内容に沿ったVRイメージをリアルタイムに自動的に生成することを目指しました。

デモ動画

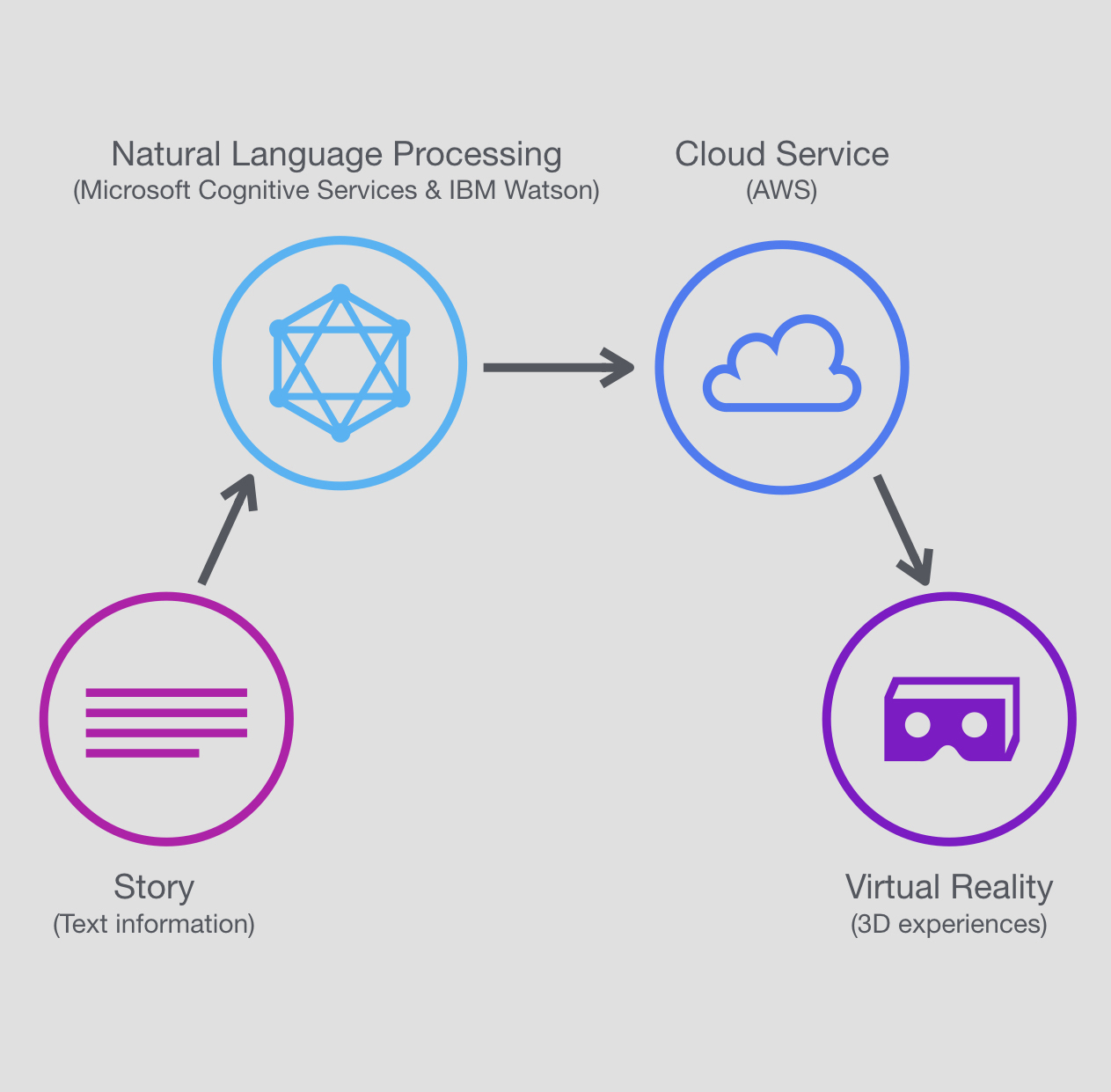

仕組み

- テキストを入力する

- APIで分析する

- Microsoft Cognitive Service >> テキストの感情分析

- IBM Watson >> テキストの自然言語処理

- 分析データをサーバーに送る (AWS)

- Unityでサーバー上のデータから、VR映像をつくる

- ローカルにあるアセットライブラリから、うさぎなどのオブジェクトを映像に配置する

- 感情分析の結果に応じて、雰囲気に合った音楽を選択する

- 「ドラゴンと戦士が戦っている」や「楽しそうなウサギ」といった文脈から、キャラクターの様子や行動を表現する

<開発の流れ>

開発に充てられたのは2日間だけなので、各自が同時進行で開発を進めなければなりませんでした。まずは、以下のツールを使ってコミュニケーションを行いました。

- Slack >> チーム内進捗共有、開発でのバグの報告

- ハッカソンFacebookグループ >> 他の参加者にヘルプを出す時

- Github >> ソースコードの編集、共有

- Google Docs >> ユーザーストーリー(体験の流れ)の共有、アイデアの整理、開発で使用するツールなどの整理

まずは、5人が同じ完成形をイメージできるよう、ユーザーストーリーを作りました。

そして、そのユーザーストーリーを実現するために最低限絶対に実装しなければいけない内容を決め、優先順位をつけて開発に進みました。問題が起きて、チーム内で解決できない場合は、メンターに聞いてアドバイスを仰いだり、他の参加者に力を借りて解決しました。

私は、クリエイティブ分野を担当し、VR上で使用する3Dモデルライブラリと音楽ライブラリを作りました。各モデルや音楽は、「悲しい」、「楽しい」といった感情によってカテゴリー分けをしていき、上記ステップ2で、文章を解析して割り出された感情値に合致するモデルと音楽を選択することにより、文字情報の雰囲気をVR上で反映させました。例えば、「剣士とドラゴンが戦う」の場合、「怒り」という感情値が出るため、怒っている剣士とドラゴンが表示され、ロックがかかるといった具合です。また、Unity上で音楽を変えるときにスムーズに音楽が切り替わるように、フェードイン、フェードアウトができるように実装しました。将来的には大規模なライブラリが必要となることは明白ですが、ハッカソンでデモを実現させるため、今回はローカルにファイルを保存することで対応しました。

(後半へ続く)