目指すゴールは「生成AI技術の民主化」Cephalon COO ツイ・ジェーアン氏インタビュー

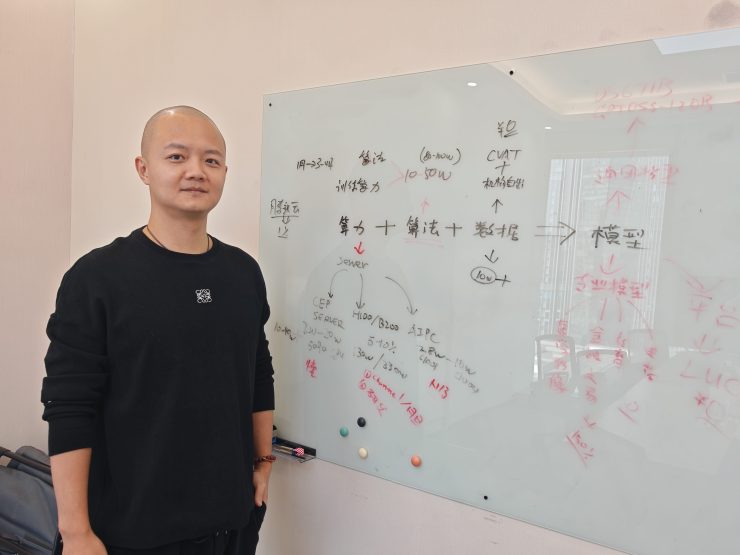

深センのCephalon本社にて同社COOの崔哲铵(ツイ・ジェーアン)氏

生成AIモデルの高度化により、コンテンツ生成や推論処理のための計算要求は急激に増大している。NVIDIA GPU の価格は高騰し、クラウド利用料の負担も大きくのしかかる。AIの利用が進む一方で、その利活用にあたっての課題は多く、超えねばならないハードルは高くなりつつある。

こうした状況に対し、深センのスタートアップ Cephalon(セファロン) は、「巨大AIモデルを既存の数倍の効率で動かすサーバ製品の販売」と「世界中の計算力をシェアする『分散算力プラットフォーム』の運営」という二本柱でビジネスを展開している。社名の「Cephalon」は、「頭部」を意味する言葉で、「GPU やモデル単体ではなく、AI を動かす計算・アルゴリズム・データすべてをつなげる存在になりたい」という思いが込められている。

今回、同社COO の崔哲铵(ツイ・ジェーアン)氏に、創業背景から技術的ブレークスルーまで詳しく話を聞いた。

分散化技術に出会い起業、そこにコロナ禍

崔氏は中国科学院大学で機械学習・計算機技術の修士過程を終了後、アップル社に入社。B2Bのクラウド技術を開発する部門で5年間勤めた。そこで、ハードウェアとソフトウェアの統合最適化の重要性を学び、優秀社員賞も受賞した。

「アップルでは、大規模コンピューティングの現場にも触れる機会があり、集中型計算の強みと限界をどちらも体験しました」と語る。

その後、ブロックチェーン分野で起業し、2017年から2022年にかけて、海外(台湾・東南アジア・中東・北米)でブロックチェーン関連の分散ネットワークビジネスを展開し、分散システム、トークンエコノミー、ノード運用、データの非中央集権化などの思想に深く関わった。だが、ブロックチェーン分野では市場化が難しく、さらにコロナ禍に見舞われたことで厳しい日々に直面した。

「中東やカナダでは、分散ネットワークの需要が非常に高かった。資金力もあり、ユーザーも積極的でした」

しかし、2020年のパンデミック以降、市場の停滞と投資の冷却により、ビジネスの継続は難しいと判断。

「当時、分散化技術の活用が期待された “メタバース”は、まだ時期尚早。だが分散化技術そのものの価値は普遍的で、AIの分野ではその価値を必要とする段階に来ていた」と崔氏は語る。

2022年には崔氏の友人も関わっていたOpenAIがChatGPTを発表、生成AIの急拡大が始まった。この状況を受けて、「計算力の民主化」を次なるテーマに据え、Cephalon の構想を具体化し始めたという。

「AI産業は 算力(計算力)・算法(アルゴリズム/フレームワーク)・データ の三要素で成り立ちます。このうち、最も不足しているのが計算力です。計算力はAIチップやメモリのようなハードウェアと、いかに効率的に計算させるかのソフトウェアの両方が必要です。自分が研究していたブロックチェーンのような“分散”の仕組みは、計算力不足の解決に応用できると考えました」

「協調」で最大化するCephalon サーバ

Cephalon のサーバ製品「C1004B」は、外観上は一般的なワークステーションに見える。しかし内部構造は大きく異なる。最大の特徴は、GPUのVRAM(Video Random Access Memory)と主メモリ(DDR)を連携させ、巨大モデルのパラメータを動的に入れ替えるソフトウェアアーキテクチャーだ。

「GPUは行列計算が得意ですが、巨大モデルはVRAMが不足しがちです。一方、CPUと主メモリは分岐処理やキャッシュ制御が得意。我々は MoE(Mixture of Experts)モデルのゲーティングやページングを CPU に割り当て、VRAMを“キャッシュ階層”として使う設計にしました」

この方式により、本来であれば複数GPUが必要な巨大モデルを、1枚のGPU(RTX 5090)でも動かせる場合がある。崔氏によると「従来構成の1/10のコストで85%程度の効率を達成できた例もある」とのことだ。

CPU(Xeon)、GPU(5090)、メモリは標準製品を使っている。しかし、マザーボードは「アーキテクチャ実現のために、全面的に自社カスタム設計した」と崔氏は話す。PCIeレーン配分、電源供給、メモリチャネル、I/O経路などを推論最適化に合わせて再設計し、CPU・GPU・メモリ間のデータ移動を最大限高速化しているという。

OSは Ubuntu がプリインストールされ、モデル群が自動起動する。ユーザーは管理者アカウントのパスワードを受け取り、SSHでも物理コンソールでも自由に操作できる。完全オフラインでの運用も可能で、企業向けの情報保護要件にも対応する。

“余った算力”をシェアするビジネス

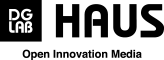

Cephalon はサーバ販売と並行して、「分散算力ネットワーク」(Cephalon Cloud) を展開している。これは、各地のGPUマシンをノードとして接続し、余った時間を他者に貸し出せる仕組みだ。

2024年時点で、ネットワークには 17,000以上のGPUチップが接続されている。売上は 年間で4,600〜7,000万元(1元=約22円)を見込み、その翌年(2025年)には 登録ユーザー1,000万、月間アクティブ100万という野心的なKPIを掲げた。

崔氏によれば、利用者は高度な専門知識を持つプロユーザーから、AIを触り始めたばかりの初心者まで幅広いという。一方で、「初心者にとってはまだ操作が複雑」という課題も認めており、UI改善や自動化ツールの開発が急務だ。

さらに、今後の最重要テーマとしては、Cephalon Cloudソフトウェアの完全オープンソース化を挙げている。

「AIインフラは一社だけの利益に閉じるべきではありません。世界中の開発者が参加できる“開かれた算力基盤”を作ることで初めて、大規模なエコシステムが生まれます」

この方針に沿って、同社は可視化ツールやローコード開発環境、さらに中国語ユーザー向けの学習フレームワークなども開発中だ。

AIインフラ再発明に挑む

崔氏の説明を通じて浮かび上がってくるのは、Cephalon が単なる AI サーバベンダーではなく、「AIインフラの構造そのものを再発明しようとしている企業」だという点だ。

Cephalonの事業戦略を言葉で表すならば「高効率サーバによって巨大モデルを低コストで動かし、分散算力ネットワークで世界中の余剰GPUを活用し、オープンソース化でエコシステムを拡大すること」と言える。

AIの普及が進むにつれ、大きな資本や設備を持たない組織や個人は「どうやって巨大な計算力を手に入れるのか」「どこで膨大なデータを処理すればいいのか」といった根源的な問題に直面している。Cephalon の取り組みは、その課題に対して新しい選択肢を提示していると言えるだろう。

ブロックチェーン技術をきっかけに生まれたこの若い企業が、世界のAIインフラの未来にどんな影響を与えるのか。今後の展開に注目したい。

OnlabがシリコンバレーVCのTransposeと仕掛ける多国籍ハッカソン「VIBE25-5」レポート|バイブコーディングでY Combinatorに挑戦

OnlabがシリコンバレーVCのTransposeと仕掛ける多国籍ハッカソン「VIBE25-5」レポート|バイブコーディングでY Combinatorに挑戦