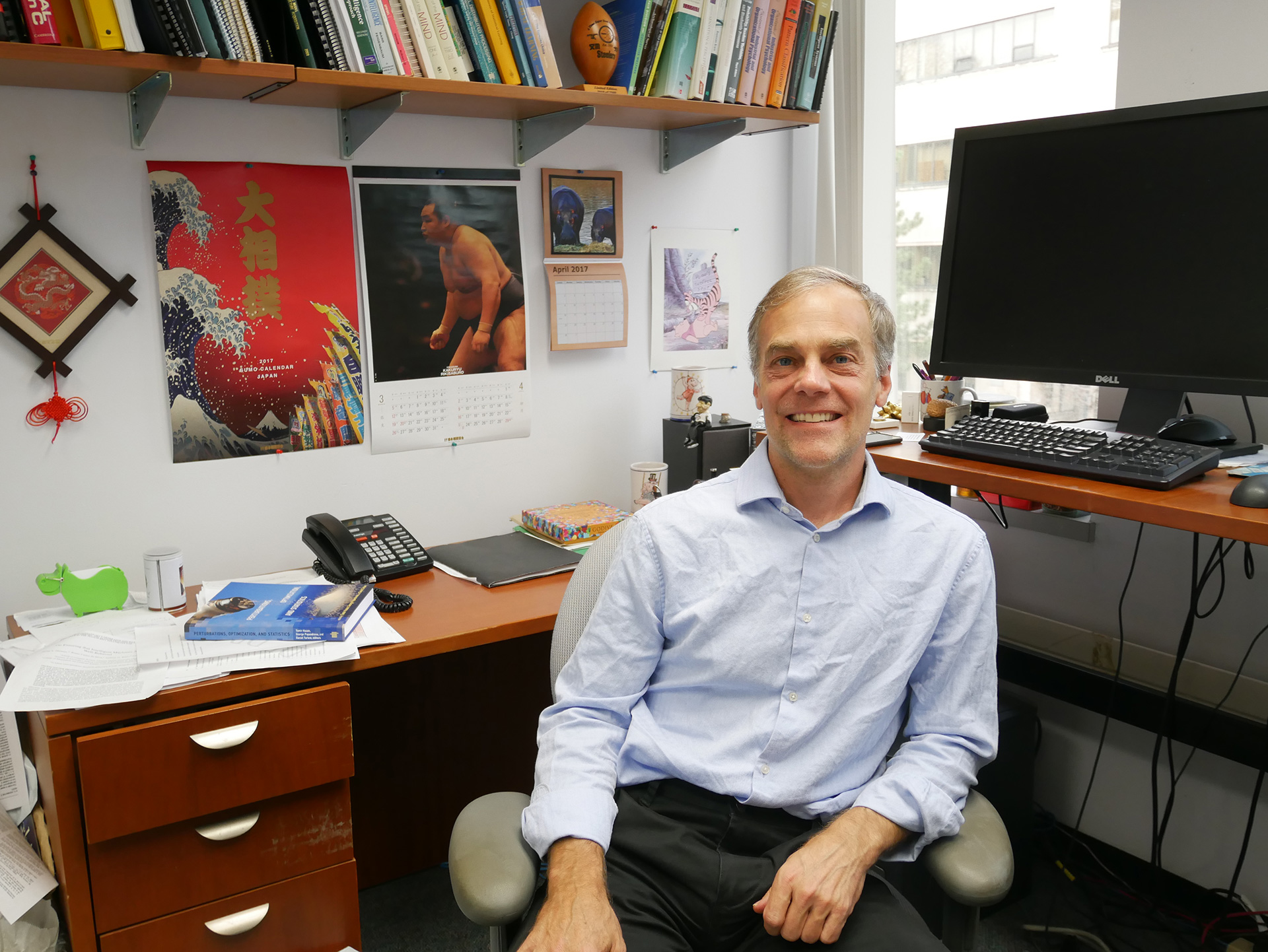

Vector Institute 研究所長・Richard Zemel教授インタビュー【前編】

フェイスブックやアップル、Google Brain、DeepMind のリーダーたちをはじめ、世界の機械学習をリードしている研究者の多くが、学生あるいはポスドク時代に、トロント大学(カナダ・オンタリオ州)の機械学習グループと何らかの形で関わってきた。この事実は、トロント大学が深層学習という分野をリードし続けてことを意味している。今回のインタビューでは、トロントの機械学習コミュニティをより強固にすべく設立された、Vector Institute 研究所長の Richard Zemel 教授に、深層学習の最新動向について聞いた。

佐久間洋司氏(以下、佐久間):ニューラルネットワークについてあまり詳しくない読者のために、Zemel 先生の現在の興味と研究について教えていただけますか?

Richard Zemel氏(以下、Zemel):「Few-Shot Learning」と呼ばれる研究にとても興味を持っています。これは、あらかじめいくつかの例を見ただけで、実際に分類をするといった類の課題です。人々は深層学習がうまく機能することは知っていますが、まず大量のラベル付けされたデータを用意する必要があり、その上でやっと機械学習システムが上手く機能し始めます。それに対して「Few-Shot Learning」はもっと難しい課題を解決することを目指します。すなわち、私たちの持っているデータは限られているという前提に立って、たったひとつ、もしくはいくつかの例から与えられた要求に対して、応えられる機械学習システムを作るのが課題になります。

実のところ人間は非常にそれを得意としています。例えば、私がどこかを旅していて、新しい果物に出会いました。それは今までに見たことのないものでしたが、誰かがそれを「ランブータン」だと教えてくれたなら、たったひとつの例を見ただけで、私はもう市場に行って数多くの果物の中からランプータンを見つけ出すことができます。どのようにして私はそれを学んだのでしょうか。人間の学習の側面で非常に興味深く、また、機械学習の観点からも取り組みがいのある課題です。

佐久間:ニューラルネットワークの学習は人間にとってあまり理解しやすいものではないため、機械学習における公平性と透明性を促進する倫理が大事だと言われています。Zemel 先生の見解をご教示いただけますか?また、法律や規制は必要だと思いますか?

Zemel:倫理に関しては、さまざまな問題が山積しています。私が、最も深く関与してきたのは公平性についてです。透明性はもうひとつの問題ですが、私はより公平性に注目しています。

かつて私は、ローン審査のデータベースを用いて、過去の意思決定を模倣してローンの審査を行う機械学習システムを構築しました。しかし、それは女性に対して差別的な判断をするシステムになってしまいました。このように機械学習システムを単に過去のデータに基づいて訓練するだけでは、人間が行ったのと同じような偏りがそのまま符号化されます。既存のデータを用いながらも偏見を持たない、差別しないシステムを構築することができるかという問題が公平性についての課題です。私はそれについて何年も前から考えてきました。それは興味深い技術的問題であり、公共政策問題であり、法的・倫理的問題でもあります。

重要な問題は、公平性の定義にもあると思っています。もしも公平なシステムというものを定義できたなら、機械学習の訓練中でも、その後の処理でも、公平性を組み込むことができるでしょう。ネットワークの出力を調整して、公平な判断ができるように試みる人々もいるようですが、それにも議論の余地はあります。現実世界の主観的なシステムから、どのように公平性を実現するのかという問題です。ただ、異なる公平性の定義に応えられる、十分に柔軟なものを検討して取り入れることはできるでしょう。どのように起こるかを具体的に述べることは難しいですが、そこにはユーザーコントロールの分野が存在すると思っています。機械学習の課題というよりは社会的な課題かもしれません。

法律や規制については、透明性を高め、世間の厳しい目に、オープンであるよう企業へ求める公共政策が必要だと思います。人々がそれを理解し、これらのシステムについて偏りをなくすよう社会から手を加えることはできます。また、プライバシーの問題も、これらの放棄や規制に関連するでしょう。

佐久間:前の質問に関連して、機械学習をビジネスに応用する際に注意すべきことはなんでしょうか。

Zemel:ひとつは、機械学習がすべての問題を解決するという誇大広告的な評判が再浮上してきたことです。最近は期待以上の性能を出しているものもありますが、それはごくわずかです。私たちが注意する必要があることは、機械学習は魔法のようなものではなく、問題を定式化し、データセットを準備することに多くの労力がかかるということです。そして、それらのデータはある程度整っており、多くの欠落があるデータではないことが必要です。課題を解決可能なものにするための前処理ステップ全体について、人々は十分な時間を費やしていません。またその部分にどれほどの労力が費やされているかについて知らないと思います。だから私はそれが非常に重要だと考えていますし、それからどのようなパフォーマンスが得られるかについての期待については疑問があります。

もしそれが本当に煩雑な問題であれば、例えば株式市場を予測しようとしているならば、それは良い情報源ではないかもしれないということを覚悟しなければいけません。実際に私が関わっている分野なので、システムを作るためにどのくらいの労力が費やされているかを知っています。それから、まったく別の問題ですが、知的財産権の問題も存在しています。

プロフィール

Richard Zemel 教授(トロント大学)

Geoffrey E. Hinton 教授のもとで1993年に博士号を取得し、2000年には計算幾科学科の教員として機械学習グループに加わる。Hinton 教授らとともにトロント大学の機械学習グループを牽引し、深層学習の黎明期を支えた。2016年に Vector Institute を設立、研究所長に就任し、トロントの機械学習コミュニティを率いている。

ストックオプション(SO)は「導入」で終わらない。Boost Healthが挑む、社員の貢献を形にする継続的な文化づくり

ストックオプション(SO)は「導入」で終わらない。Boost Healthが挑む、社員の貢献を形にする継続的な文化づくり