人と合奏するAIに足りないものは?

デジタルコンテンツエキスポ(日本未来科学館)で、AIと人間の自然な合奏を可能にする『人工知能合奏システム』

人工知能(AI)が「演奏する」「作曲する」というニュースは珍しくはなくなった。では、一歩進んで人との「合奏(アンサンブル)」はできるのだろうか。

バンドなどの経験がある人はわかると思うが、仲間同士で合奏するのは難しい。楽譜の解釈やその表現の仕方は人それぞれで、何度か一緒に練習すると息が合ってくる。この「息が合う」というのは何とも数値化しにくいものに思える。さらにアドリブ(即興演奏)で演奏となるとさらに難しい。人は、アイコンタクトで、タイミングを察し、雰囲気をつかんでソロを奏でるなど「掛け合い」を楽しむことができるのだが、これが人工知能に可能だろうか?

人間同士が行っていた「合奏」の世界に、1980年代、MIDI(ミディ・デジタル音楽を制御するための統一規格)が登場し、人とコンピュータの合奏が実現した。しかしそれは、「息を合わせた」合奏ではなく、コンピュータが出す正確なクリック音(テンポを合わせるためのメトロノーム音)の「ガイド」に人間が合わせて演奏するで、アドリブのやり取りなどということはできない。コンピュータへの入力は人間が行うが、いざ演奏になると、コンピュータの指示に人間が粛々と従うことになる。

そして近年、AIが音楽の分野にも分け入ってきた。作曲するAIの登場にも驚かされたが、今度は、ヤマハ株式会社が10月27日からのデジタルコンテンツエキスポ(日本未来科学館)で、AIと人間の自然な合奏を可能にする『人工知能合奏システム』を発表するという。

これは、「バーチャルな演奏者と人との合奏」という新しい音楽の楽しみ方を提案するもの。2年がかりで開発され、AIが人間の演奏をリアルタイムに解析し、人間と息の合った合奏を行うことができるという。

人間の演奏ペースにAIが合わせる

会場のヤマハブースでは、すでにトランペットやユーフォニアムを持ち込んで、『人工知能合奏システム』に合わせ、プレイヤーが試奏していた。前述のように、これまでコンピュータと合奏をするときには、コンピュータの「ガイド」にあわせて演奏するのが標準だった。というか、そうしないと合奏が成立しない。ところが、今回はガイドがない。プレイヤーは楽譜を見ながら、AIと息を合わせて演奏していた。最初、プレイヤーが少々戸惑う気配も見られたが、ペースがつかめると徐々に合奏として成立してくるようだ。

このプロジェクトの陣頭指揮をとっていた石川克己氏(ヤマハ新規事業開発部マーケティンググループリーダー)に話を聞いた。

― これはあらかじめシステムの中に楽譜が入っているのですか?

入っています。楽譜をベースとして、人間の演奏者がゆっくり演奏(リタルダンド)した場合にも、それにあわせてAIはついてきます。間違えた場合は、もう一度その部分に戻って弾き直すといったこともします。演奏に迷っているな、と判断したら人間を待っていてくれたりとか。

― 人間だと目で合図したりしますよね。

今のところは、AIはあくまで人間の出した音と、楽譜との整合性をとって判断していますね。

― たとえば、人間がアドリブを行ったら、AIが返してくれる(掛け合い)なんてできないのですか?

まだそこまでいっていませんね。しかし今後は、人間のアドリブに応えてAIがアドリブを返す、なんてところまでは行きたいです。

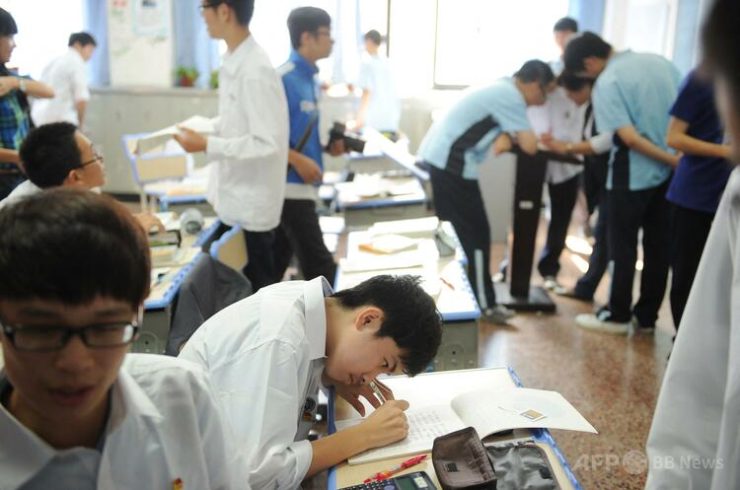

会場のホールでは、『人工知能合奏システム』を使ってのデモライブが行われた。プロのユーフォニアム奏者今村耀(いまむら・よう)さんがAIと2人(?)での演奏を聴かせてくれる。ガイドもなく、まさにAIと息を合わせて演奏しているようだ。

この日『人工知能合奏システム』と合奏をしたプロのユーフォニアム奏者今村耀(いまむら・よう)さん

演奏の後、今村さんは「AIとは最初どうやって息を合わせていいかわからなかったが、何回か演奏しているうちに息が合ってきた。まるで人と合わせていくような感じ」とコメント。また、「演奏に合わせてくれるのもいいが、もっと和音、倍音などをしっかり出してほしい」と、プロ奏者らしい要求も忘れなかった。

「ビッグ」ではなく「スモールデータ」を利用

開発を担当した前澤陽氏(ヤマハ第1研究開発部知的音楽システムグループ)にも話を聞いた。

* * *

― AIの開発はオープンソース等を使ったのですか?

いえ、すべて自社で開発したものです。

― ヤマハといえば、膨大な音源や譜面などビッグデータを持っていると思います。そういったビッグデータをAIの学習に生かしたのですか?

いえ、開発のキーはスモールデータでした。

― スモールデータ?

(コンサートでの演奏など)たくさん集められるデータがあります。その一方で人間がどう演奏するか、たとえば今村耀さんだったらこう吹くということは、スモールデータなんです。少ないデータをもとに数式を設定して、そこにまたちょっと数式を加えるという調整にたいへん苦労しました。

― 他に開発で苦労されたことは?

人間が(AIとの合奏を)自然に感じられるかどうかということです。人間がその場その場でどう感じるか。自分が出した音で、相手(AI)の音も変わるかもしれない。AIの音がちょっとコケたら人間の演奏もコケてしまう。それをいかにコケないように数式を組んでいくか……。試行錯誤でしたね。そこを実際のアーティストに試してもらいながら調製を重ねました。

― プロのアーティストとのやり取りがずいぶんあったのですね。そこはヤマハの強みですね。

まさしくそうかもしれません。弊社はミュージシャンとのつながりは強いです。そして、ミュージシャンにとって気持ちいい合奏ができるというのを追求していきたかったのです。ミュージシャンの「もっとここはこんな感じで」というような音楽的な言葉を、工学的な数理モデルの数式に落とし込んでいけるのがわれわれの強みでしょうか。

― 今後、こうしていきたいというような方向性はありますか?

ベルリンフィルの人たちに試奏してもらったとき、「ユーモアが足りない」と言われたんですよ。ユーモアとは? 演奏を合わせるだけではダメで、その先を見通すことなんだと思うのです。データとして返すだけではなくて、自分の出したものに対してもうちょっと何か返してほしい、「掛け合い」の感覚というのでしょうか。その「掛け合い」の感覚を数理的にモデル化するのはたいへん難しいところです。ただ、自分は、楽しく合奏できないと意味ないと思いますし、そこを追求するのは大事なことだと感じています。

石川氏に聞いた「AIとのアドリブとの掛け合い」について同じことを聞いてみたが、やはりそこは追いかけていきたい部分だと意識しているようだ。「AIと人間との息の合ったアドリブの掛け合い」。それは思ったより早く、実現するのかもしれない。

【参考】AIとの合奏の様子を動画で「AIと人間が合奏に挑戦―みらいのアンサンブル」

スタートアップのM&A成功に向けて知っておくべき7つのTIPs

スタートアップのM&A成功に向けて知っておくべき7つのTIPs