脳活動信号から聞いた内容を再現 ブレイン・コンピュータ・インターフェイス最前線

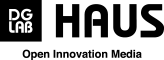

脳活動信号から聞いた内容を再現(イメージ図)

重篤で意識がないように見える患者であっても、話しかけた言葉は当人には聞こえているかもしも知れない。筆者自身も体験したことだが、肉親が昏睡に至った際にかけた言葉は、はたして本人には届いていたのだろうか。今、それを知るすべはない。

私たちは、音声によってコミュニケーションを行う。自分の発した言葉は、自分の耳で確認できる。そして相手にも同じ音声が届いているものとして会話は進むが、実際相手の耳が捉え、脳に届いた音声を話し手が確認する事はできない。普段、そういった確認は必要ない。しかし冒頭のようなケースの他にも、身体の障害や重い病気によって、音声の伝達がスムーズに行かない場合などでは、聞こえているのか、あるいは聞こえているとしても、こちらの意図した内容が理解できる形で届いているのかを外部から確認することは難しい。

脳活動信号から読み取りAIで音を再現

現在、ブレイン・コンピュータ・インターフェイスという脳神経の活動から信号を読み取り、解析する技術が各国で進んでいる。2021年1月、東京工業大学 科学技術創成研究院の吉村奈津江准教授(科学技術振興機構さきがけ研究員兼務)、明石航大学院生(研究当時)、神原裕行助教、緒方洋輔特任助教(研究当時)、小池康晴教授、ルドビコ・ミナチ特定准教授のグループは、頭皮で記録された脳波信号(脳内の神経細胞の活動を反映した電気信号を頭皮に付着した電極から記録した信号)から音声を直接再構築するために有望な手法を開発したと発表した。今回、吉村准教授にその研究内容について、お話を伺うことができた。

* * *

私たちが何か考えるたびに、神経細胞は活動電位を発火(スパイク)させる。脳の中の無数のスパイクが集まって合成波となり、脳から頭蓋骨を経て、頭皮まで弱い信号が伝わる。今回の実験では、参加者に水泳帽のようなものをかぶってもらい、そこに装着されたセンサーによって32ヵ所から脳波信号を読み取った。

まず、参加者には「ア」と「イ」の2つの母音と、白色雑音(ホワイトノイズ:広い周波数帯が均一に混入した雑音)を聞かせる。その1~2秒後に、たったいま聞いたところのこれらの音を思い出してもらい「音を聞いている時」と「音を思い出している時」の脳波信号を計測する。この脳波信号を「畳み込みニューラルネットワーク(※)」を用いAI(人工知能)に分析させ、聞いたはずの音を合成、復元させた。

さらに、その復元された音声を、人の耳で聞き分けられるかどうか、聞き取り判別試験を行ったところ、全ての参加者の脳波データにおいて、8割程度の判別が可能だったという。

「これは極めて高い精度だと言えます」(吉村氏)

今回は、2種類の母音の違いだけを調べた研究だが、この技術をさらに進歩させることで、個人の脳内の聴覚・音声・言語処理のさらなる理解に貢献できると期待されるという。

※広義の人工知能、機械学習法のひとつで、脳内の神経細胞がネットワークを形成して情報伝達を行う事象を模して数式的なモデルとして表現し、入力された情報の中から目的とする出力を構成するために必要な情報を抽出するために利用できる。(東京工業大学リリースより引用)

人体を傷つけない手法

脳波信号というのは、神経細胞が発火したものが無数にミックスされかつ減衰して頭皮から記録されるので、細かな情報はとれない、というのが一般的な概念だったが、今回の研究成果は新たな可能性につながるものだ。

「現状のブレイン・コンピュータ・インターフェイスでは、“脳のこのあたりで右手の運動を考えましたよ”、“左手の運動を考えましたよ”という大まかな情報を抽出する手法が実用化に向かっていますが、それよりもっと細かい情報が解読できる可能性を示せたのです」(吉村氏)

海外の研究では、頭部に外科的手術を施し、脳皮質表面にセンサーをかぶせて測定する「皮質脳波」を使って、言葉のフレーズを再生する試みが行われており、それに関する研究成果も公表されている。

「それは一般の人からすると、『ア』とか『イ』だけの再現よりインパクトのある発表だとは思いますが、音声としてクリアに再現できているかというと、まだそこまでできていないのです。私たちの頭皮から脳波を記録して分析する手法で、どこまでできるのか研究していきたい」

頭の中にセンサーを埋め込むという話には抵抗感を抱かざるを得ない。吉村氏らの研究の長所は「非侵襲的(身体を傷つけることがほとんどない)」であることだ。頭皮に電極を装着するだけなので、極めて抵抗感が少ない。

今後は「ア」や「イ」以外にもいろんな音を試していく予定だという。また音楽のメロディーなどの再現についても、「技術的には可能になります。“この人には、このメロディーはどう聞こえているのか”という状態を復元することができるようになるのではないかと期待しています」と吉村氏は話す。

さらに、今は外からうかがい知ることのできない実情も、多くの実例を調べていけば分かってくるはずと吉村氏は続ける。難聴の人が、耳に近い部分までは聞こえているけれど、脳の認知的な部分で聞こえてないのか。あるいは「音」として聞こえているけれど、「言語」として聞こえていないのか、そのあたりが解明できるのではないかという期待がある。

ブレイン・コンピュータ・インターフェイス研究の課題

脳波から言語を読み取るということはほんとうに難しい。現在の研究成果で、ブレイン・コンピュータ・インターフェイスから、「運動をしよう/やめよう」などというような大まかなことについてはリアルタイムで読み取ることが可能になっている。

しかしブレイン・コンピュータ・インターフェイスで、考えたことをリアルタイムで言葉にしていくには、巨大なマシンパワーが必要になるため、技術的な課題は大きいとのことだ。ただしその中でも、吉村氏らの進める「聞いた音はちゃんと聞こえているのか」という研究においては、一度データを取得すればいいので、現状でも実用化に近いのでは、と自信を示した。

ただ、吉村氏は医学系の学部を有しない東京工業大学の准教授であるため、今後研究を進めていくにあたってはメディカル分野の協力も不可欠となることが予想される。またさらに多くのデータを収集する必要もあり、研究には手間もコストがかかる。課題はまだまだ多く、こうした研究に興味を示してくれる方たちの支援があればと最後に吉村氏は話した。

スタートアップのM&A成功に向けて知っておくべき7つのTIPs

スタートアップのM&A成功に向けて知っておくべき7つのTIPs